【項目動态】深蘭DeepBlueAI團隊少量數據關系抽取論文被(bèi)錄用!

近日,EMNLP 2021在官網提前公布了今年的論文審稿結果,DeepBlueAI團隊的論文《MapRE: An Effective Semantic Mapping Approach for Low-resource Relation Extraction》被(bèi)錄用。該論文提出了在低資源關系提取任務中融合同類别樣(yàng)本間句子相關性信息和關系标簽語義兩(liǎng)個方面(miàn)的信息的方法,并在多個關系提取類任務的公開(kāi)數據集的實驗中得到了SOTA結果。

EMNLP(全稱Conference on Empirical Methods in Natural Language Processing)由ACL SIGDAT(語言學(xué)數據特殊興趣小組)主辦,每年舉辦一次,在Google Scholar計算語言學(xué)刊物指标中排名第二。主要關注統計機器學(xué)習方法在自然語言處理領域的應用,近幾年随著(zhe)大規模數據的機器學(xué)習方法的發(fā)展,該會議人數逐年增加,受到越來越廣泛地關注。

EMNLP論文入選标準極爲嚴格,EMNLP 2021共收到有效投稿3114篇,錄用754篇,錄用率僅爲24.82%。按照慣例,EMNLP 2021評選了最佳長(cháng)論文、最佳短論文、傑出論文和最佳Demo論文四大獎項,共7篇論文入選。

今年EMNLP 2021 將(jiāng)于11月7日 - 11日在多米尼加共和國(guó)蓬塔卡納和線上聯合舉辦,會議爲期五天,複旦大學(xué)計算機科學(xué)學(xué)院教授黃萱菁將(jiāng)擔任本次會議的程序主席。在即將(jiāng)召開(kāi)的EMNLP學(xué)術會議上將(jiāng)展示自然語言處理領域的前沿研究成(chéng)果,這(zhè)些成(chéng)果也將(jiāng)代表著(zhe)相關領域和技術細分中的研究水平以及未來發(fā)展方向(xiàng)。

DeepBlueAI團隊的論文提出了在低資源關系提取任務中融合同類别樣(yàng)本間句子相關性信息和關系标簽語義兩(liǎng)個方面(miàn)信息的方法,并在多個關系提取類任務的公開(kāi)數據集的實驗中得到了SOTA結果。

關系提取旨在發(fā)現給定句子中兩(liǎng)個實體之間的正确關系,是NLP中的一項基本任務。該問題通常被(bèi)視爲有監督的分類問題,由大規模标記數據進(jìn)行訓練。近年來,關系提取模型得到了明顯的發(fā)展。然而,訓練樣(yàng)本過(guò)少時,模型性能(néng)會急劇下降。

在最近工作中,DeepBlueAI團隊利用小樣(yàng)本學(xué)習的進(jìn)步來解決低資源問題。少樣(yàng)本學(xué)習的關鍵思想是學(xué)習一個用來比較query和support set samples中樣(yàng)本相似度的模型,這(zhè)樣(yàng),關系抽取的目标從學(xué)習一個通用的、準确的關系分類器變爲學(xué)習一個將(jiāng)具有相同關系的實例映射到相近區域的映射模型。

在少樣(yàng)本學(xué)習的設定下,标簽信息,即包含關系本身語義知識的關系标簽,在訓練和預測時并沒(méi)有被(bèi)模型用到。DeepBlueAI團隊的實驗結果表明,在預訓練和微調中結合上述标簽信息和各關系類别的樣(yàng)本兩(liǎng)類映射可以顯著(zhe)提高模型在少樣(yàng)本關系提取任務上的表現。

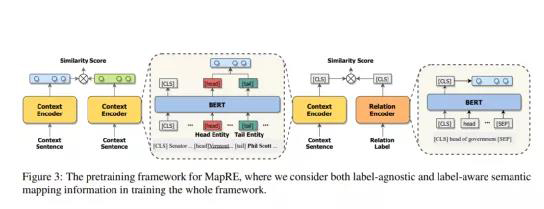

01語義映射預訓練

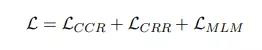

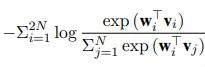

預訓練部分的目标函數由三個部分組成(chéng):

CCR: 樣(yàng)本表示間損失

CRR:樣(yàng)本與标簽間損失

MLM:語言模型損失,同BERT

DeepBlueAI團隊采取類似CP (Peng et al., 2020)的方法中對(duì)模型進(jìn)行預訓練。不同之處在于團隊還(hái)考慮了标簽信息,使用Wikidata作爲預訓練語料庫,去除了Wikidata和DeepBlueAI團隊用于後(hòu)續實驗的數據集之間的重複部分。

本部分中,DeepBlueAI團隊使用BERT base作爲基礎模型,采用AdamW優化器,最大輸入長(cháng)度設置爲60。DeepBlueAI團隊共訓練了11,000步,其中前500步爲warmup,batch size設爲2040,學(xué)習比率爲3e-5。

02監督性關系抽取

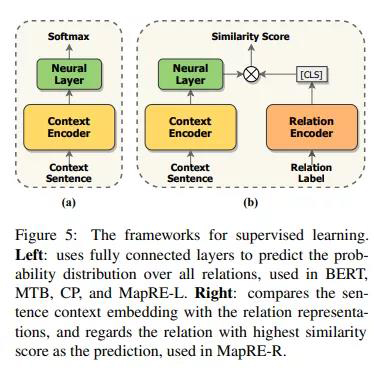

本部分DeepBlueAI團隊一共試驗了MapRE預訓練模型的兩(liǎng)種(zhǒng)使用方式,即MapRE-L(直接使用全連接層對(duì)文本編碼輸出預測關系)和MapRE-R(采用關系編碼器編碼關系标簽,再做相似度匹配),模型結構如圖:

在監督性關系抽取任務中DeepBlueAI團隊評估兩(liǎng)個基準數據集:ChemProt和Wiki80。前者包括56,000個實例和80種(zhǒng)關系,後(hòu)者包括10,065個實例和13種(zhǒng)關系。

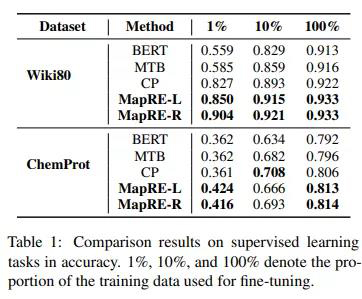

實驗結果如下:

這(zhè)裡(lǐ)DeepBlueAI團隊重點關注低資源關系抽取,選取以下三個有代表性的模型進(jìn)行比較。

1)BERT:該模型在文本的頭實體和尾實體部分分别增加特殊的标記token,在BERT輸出後(hòu)接幾個全連接層用于關系分類。

2)MTB (Soares et al., 2019):MTB模型假設無監督數據中頭實體和尾實體相同的句子均爲正樣(yàng)本對(duì),即具有相同的關系。在測試階段,對(duì)query和support set的相似度得分進(jìn)行排名,將(jiāng)得分最高的關系作爲預測結果。

3)CP (Peng et al., 2020):同MTB類似,我們的方法同CP模型的不同點在于,我們在預訓練和微調時均考慮了标簽信息。

我們可以觀察到:

1)在BERT上進(jìn)行預訓練(即MTB, CP和MapRE)可以提高模型性能(néng)

2)比較MapRE-L與CP和MTB,在預訓練期間添加标簽信息可以顯著(zhe)提高模型性能(néng),尤其是在資源極少的情況下,例如僅1%的訓練集用于微調

3) 比較 MapRE-R 和 MapRE-L,其中前者在微調中也考慮了标簽信息,表現出更好(hǎo)更穩定的實驗結果

結果表明在預訓練和微調中使用标簽信息均可顯著提高低資源監督性關系抽取任務上的模型性能(néng)。

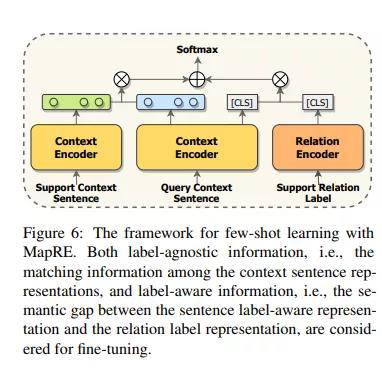

03少樣(yàng)本與零樣(yàng)本關系抽取

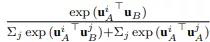

在少樣(yàng)本學(xué)習的情況下,模型需要在隻有給定一定關系類别,每個類别少數樣(yàng)本的情況下進(jìn)行預測。對(duì)于N way K shot問題,Support set S包含N個關系,每個關系有K個樣(yàng)本,查詢集包含Q個樣(yàng)本,每個樣(yàng)本屬于 N 個關系之一。

該模型結構如下:

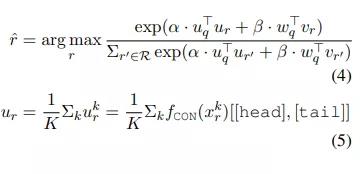

模型預測結果由下式得出:

DeepBlueAI團隊在兩(liǎng)個數據集上評估提出的方法:FewRel和NYT-25。FewRel 數據集包含70,000個句子和100個關系(每個關系有700個句子),數據來源爲維基百科。其中64個關系用于訓練,16個用于驗證,以及20個用于測試。測試數據集包含 10,000 個句子,必須在線評估。NYT-25數據集是由Gao et al., 2019。DeepBlueAI團隊随機抽取 10 個關系用于訓練,5 個用于驗證,10 個用于測試。

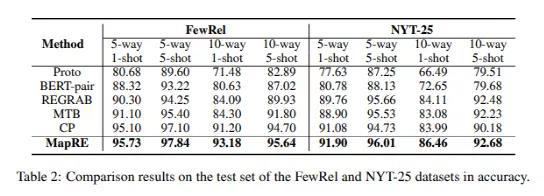

實驗結果如下:

如上表所示,在所有的實驗設置下,DeepBlueAI團隊提出的MapRE,由于在預訓練和微調中均考慮了support set樣(yàng)本句子和關系标簽信息,提供了穩定的性能(néng)表現,并大幅優于一系列baseline方法。結果證明了團隊提出的框架的有效性,并表明了關系抽取中關系标簽語義映射信息的重要性。

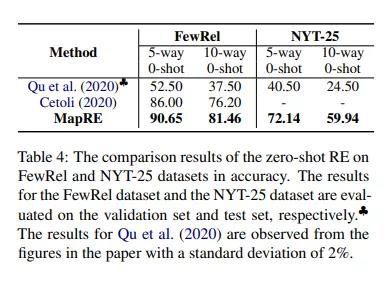

DeepBlueAI團隊進(jìn)一步考慮了低資源關系抽取的極端條件,即零樣(yàng)本的情況。在該設定下,模型輸入不包含任何support set樣(yàng)本。在零樣(yàng)本條件下,以上大部分少樣(yàng)本關系抽取框架不适用,因爲其它該類模型的每個關系類别中至少需要有一個樣(yàng)本。

結果表明,與其它最近零樣(yàng)本學(xué)習工作相比,DeepBlueAI團隊提出的MapRE在所有設定下都(dōu)獲得了出色的表現,證明了MapRE的有效性。

總結

在這(zhè)項工作中,DeepBlueAI團隊提出了一種(zhǒng)同時考慮标簽信息和樣(yàng)本信息的關系抽取模型,MapRE。大量實驗結果表明,MapRE模型對(duì)監督性關系抽取、少樣(yàng)本關系抽取和零樣(yàng)本關系抽取任務中展示了出色的表現。結果表明樣(yàng)本和标簽信息兩(liǎng)者在預訓練和微調中都(dōu)起(qǐ)到了重要作用。在這(zhè)項工作中,DeepBlueAI團隊沒(méi)有研究領域遷移造成(chéng)的潛在影響,我們將(jiāng)相關分析作爲下一步的工作。

綜上,深延科技提出的MapRE模型結合了零樣(yàng)本和少樣(yàng)本學(xué)習的特點,結合了同關系樣(yàng)本和關系語義兩(liǎng)個方面(miàn)的信息,目前已在深延科技智能(néng)數據标注平台文本關系抽取功能(néng)中得以應用,大幅提升了模型在少量訓練樣(yàng)本下的表現,在數據的智能(néng)标注等領域可大幅節省人力,提升标注效率及标注質量。