【項目動态】ECCV 2020首屆GigaVision挑戰賽 深蘭包攬十億級像素雙賽道(dào)冠軍

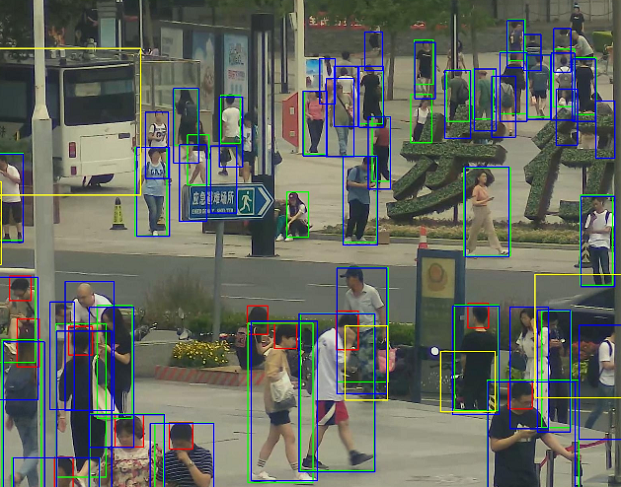

過(guò)去十年中,行人檢測、跟蹤、動作識别、異常檢測、屬性識别等以人爲中心的計算機視覺分析任務引起(qǐ)了人們的極大關注,爲了促進(jìn)新的算法來理解大規模現實世界場景中複雜的人群活動及社交行爲,可把圖像放大千倍的十億級别像素目标檢測,將(jiāng)在例如人臉識别、無人駕駛、監控安防和智能(néng)手機等多個領域被(bèi)廣泛應用。

計算機視覺作爲深蘭科技的核心技術之一,其實力已在多個國(guó)際頂會競賽中得以驗證,并已應用于不同領域的産品中,包括疫情期間發(fā)揮了極大作用的深蘭AI熱感視覺行爲監控系統-貓頭鷹,在廣州、深圳、武漢、上海、長(cháng)沙等多地獲得自動駕駛路測牌照的熊貓智能(néng)公交車,以及各類機器人和智能(néng)零售産品等。

雙賽道(dào)冠軍方案

本次的挑戰賽同時是ECCV2020的Workshop:「GigaVision: When Gigapixel Videography Meets Computer Vision」。

Sub-Track 1 : Pedestrian & Vehicle Detection

這(zhè)項任務是爲了推動在十億像素圖像上的目标檢測技術的發(fā)展。挑戰的參與者需要檢測兩(liǎng)類目标:行人和車輛。對(duì)于每個行人,需要提交三類檢測框:可見身體範圍框、全身範圍框、行人頭部範圍框。對(duì)于每個車輛,需要提交可見範圍框。一些特殊的區域(如假人、極度擁擠的人群、車群、被(bèi)嚴重遮擋的人等)將(jiāng)在評估中被(bèi)忽略。

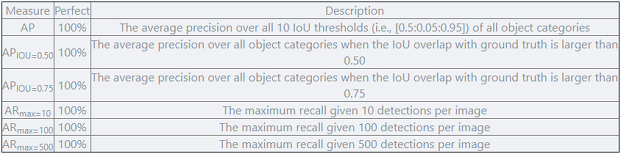

Sub-Track 2 : Multi-Pedestrian Tracking

這(zhè)項任務是爲了推動在十億像素視頻上的多目标追蹤技術的發(fā)展。PANDA寬視場、多目标、高分辨的優越性能(néng)使特别适合于多目标長(cháng)時間追蹤任務。然而,巨大的同類目标尺度變化和擁有豐富行人擁擠、遮擋的複雜場景也帶來了各種(zhǒng)挑戰。在給定輸入視頻序列的情況下,該任務需要參與者提交行人在視頻中的軌迹。對(duì)于賽道(dào)一,類似于MS COCO數據集的評估方案,主辦方采用AP、APIOU=0.50、APIOU=0.75、ARmax=10、ARmax=100、ARmax=500五個指标來評估檢測算法的結果。最終的排名依據于 AP 和 ARmax=500 兩(liǎng)項指标的調和平均數,高者爲優。

對(duì)于賽道(dào)二,與MOTChallenge[2]中使用的評測方法類似,主辦方采用了包括MOTA、MOTP、IDF1、FAR、MT和Hz等指标來評估多目标追蹤算法的結果。最終的排名依據于 MOTA 和 MOTP 兩(liǎng)項指标的調和平均數,高者爲優。

任務二:

圖像分辨率極高、近景和遠景目标尺度差異大

十億像素級的超高分辨率是整個數據集的核心問題。一方面(miàn),由于計算資源的限制,超高分辨率使得網絡無法接受大圖作爲輸入,而單純將(jiāng)原圖縮放到小圖會使得目标丢失大量信息。另一方面(miàn),圖像中近景和遠景的目标尺度差異大,給檢測器帶來了巨大的挑戰。

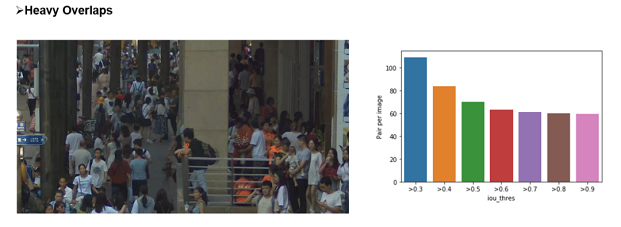

目标在圖像中分布密集,并且遮擋嚴重

數據集均從廣場、學(xué)校、商圈等真實場景采集,其人流和車輛密度極大。同時,行人和車輛的擁擠、遮擋等情況頻發(fā),容易造成(chéng)目标的漏檢和誤檢。

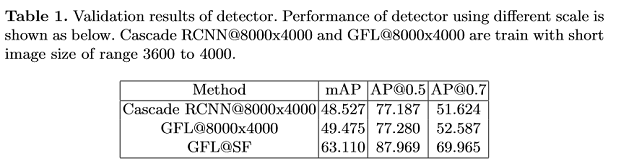

根據以往積累的經(jīng)驗,團隊首先將(jiāng)原圖縮放到合适尺度,并使用基于Cascade RCNN的檢測器直接檢測行人的三個類别和車輛,將(jiāng)其作爲Baseline: Backbone + DCN + FPN + Cascade RCNN,并在此基礎上進(jìn)行改進(jìn)。

實驗結果顯示,模型存在大量的誤檢和漏檢。這(zhè)些漏檢和無意義的檢測結果大幅降低了模型的性能(néng)。團隊將(jiāng)上述問題歸納爲兩(liǎng)方面(miàn)的原因:

1、訓練和測試時輸入模型的圖像尺度不合适。圖像經(jīng)過(guò)縮放後(hòu),目标的尺度也随之變小,導緻遠景中人的頭部等區域被(bèi)大量遺漏。

2、網絡本身的分類能(néng)力較弱。行人的可見區域和全身區域十分相似,容易對(duì)分類器造成(chéng)混淆,從而産生誤檢。

根據上述問題,團隊進(jìn)行了一些改進(jìn)。

首先,使用滑動窗口的方式切圖進(jìn)行訓練。滑動窗口切圖是一種(zhǒng)常用的大圖像處理方式,這(zhè)樣(yàng)可以有效的保留圖像的高分辨率信息,使得網絡獲得的信息更加豐富。如果某個目标處于切圖邊界,根據其IOF大于0.5來決定是否保留。

其次,對(duì)于每個類别采用一個單獨的檢測器進(jìn)行檢測。經(jīng)過(guò)實驗對(duì)比,對(duì)每個類别采用單獨的檢測器可以有效的提高網絡的效果,尤其是對(duì)于可見區域和全身區域兩(liǎng)類。

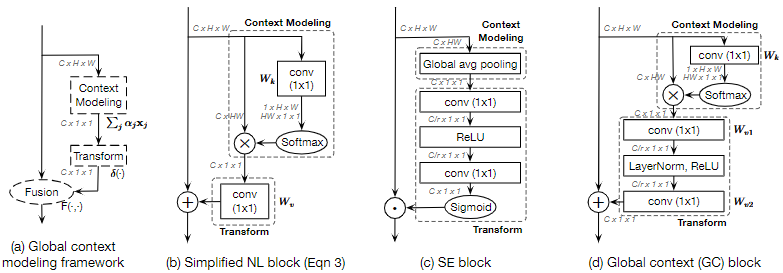

同時向(xiàng)檢測器添加了Global Context (GC) block來進(jìn)一步提高特征提取能(néng)力。GC-Block結合了Non-local的上下文建模能(néng)力,并繼承了SE-Net節省計算量的優點,可以有效的對(duì)目标的上下文進(jìn)行建模。

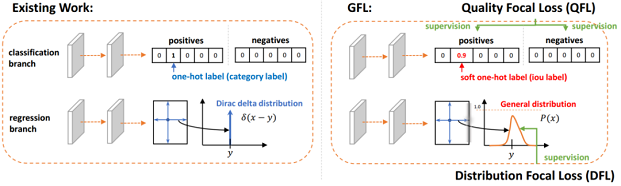

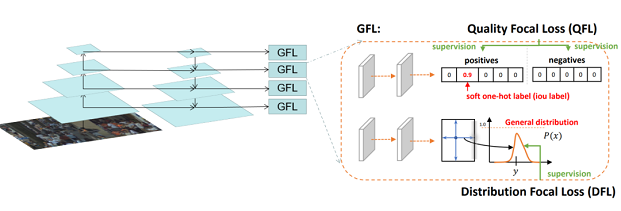

除Cascade RCNN外,還(hái)采用了Generalize Focal Loss (GFL)檢測器進(jìn)行結果互補。GFL提出了一種(zhǒng)泛化的Focal Loss損失,解決了分類得分和質量預測得分在訓練和測試時的不一緻問題。

最後(hòu),將(jiāng)各檢測器的結果使用Weighted Box Fusion (WBF)進(jìn)行融合,形成(chéng)了最終的解決方案。

傳統的NMS和Soft-NMS方法會移除預測結果中的一部分預測框,而WBF使用全部的預測框,通過(guò)進(jìn)行組合來獲得更加準确的預測框,從而實現精度提升。整體pipeline如下圖所示:

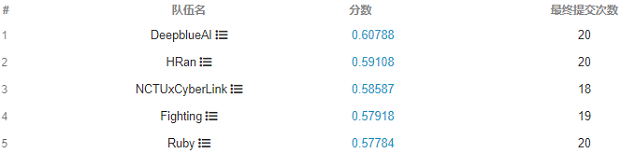

實驗結果:

賽題分析

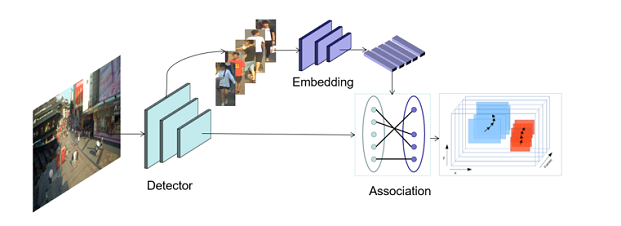

多行人跟蹤問題是一個典型的多目标跟蹤問題。通過(guò)調研總結發(fā)現,Tracking-by-detection是處理這(zhè)一問題的常用且精度比較高的方法[2][7]。基本的流程可以總結如下:

1) 在每一幀中檢測物體的位置。2) 爲每個檢測框提取特征。3) 通過(guò)將(jiāng)特征距離或空間距離將(jiāng)預測的目标與現有軌迹關聯。

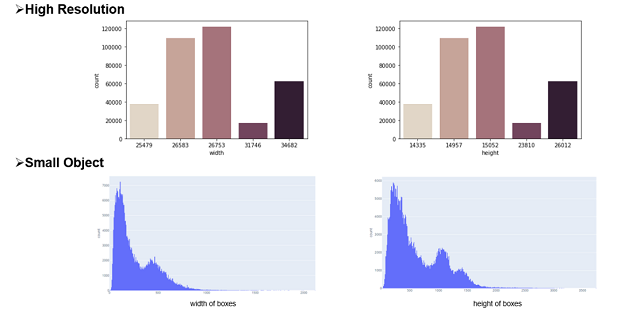

本次挑戰賽更注重精度,因此采用了分離Detection和Embedding的方法,該方法的模塊化設計的優點使得競賽精度上優化空間的十分大。通過(guò)簡單的數據統計分析和可視化分析,團隊認爲該比賽的主要挑戰在于圖像的大分辨率和行人的嚴重擁擠,如下圖所示。

爲了應對(duì)這(zhè)些挑戰,針對(duì)高分辨、小目标等問題,引入了一種(zhǒng)滑動窗口檢測算法。針對(duì)遮擋嚴重的問題,使用局部和全局特征來衡量兩(liǎng)個相鄰幀之間的預測邊界框的相似距離,并且借鑒了FairMOT的特征平滑的方法進(jìn)行緩解。

競賽方案:

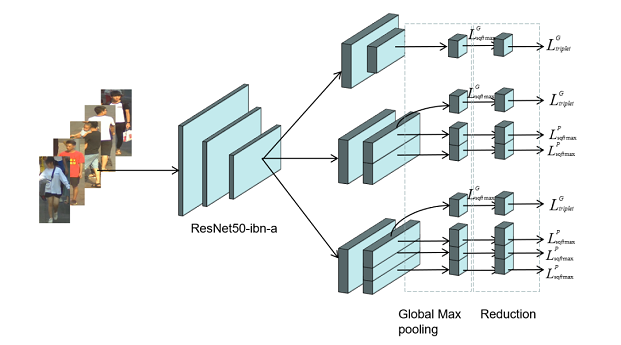

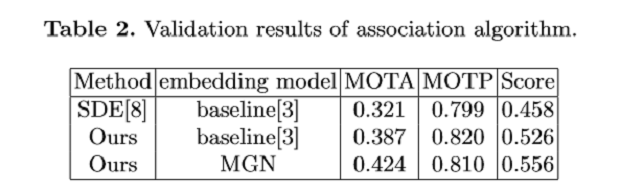

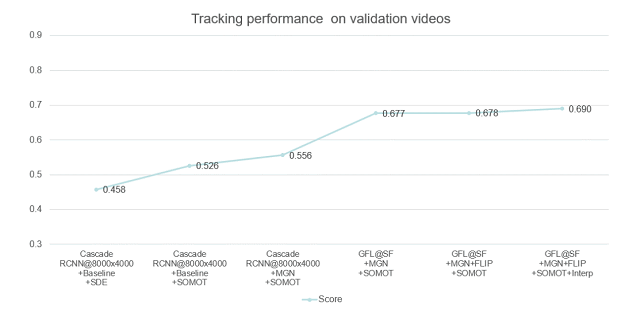

本次采用的多目标跟蹤系統是基于Detection和Embedding分離的方法,采用了以Generalized Focal Loss(GFL)[9]爲損失的anchor-free檢測器,并以Multiple Granularity Network (MGN)[10]作爲Embedding模型。

在關聯過(guò)程中,借鑒了DeepSORT[6]和FairMOT[8]的思想,構建了一個簡單的在線多目标跟蹤器, 如下圖所示。

檢測器

檢測部分:

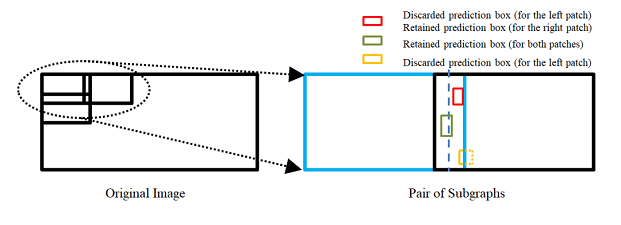

爲了處理高分辨率的圖像,我們提出了一個segmentation-and-fusion(SF)的方法,如下圖所示。每一張大圖有交疊的切分成(chéng)多個子圖,每一個子圖的分辨率爲6000*6000,位于圖像邊緣的子圖直接填充均值。爲了防止較大的行人目标被(bèi)切分成(chéng)進(jìn)兩(liǎng)個子圖,相鄰的子圖橫向(xiàng)上重疊寬度爲1000像素,縱向(xiàng)重疊寬度設置爲2000像素。在融合子圖檢測結果時,我們采用一種(zhǒng)基于子圖重疊中線和檢測框相交判定的規則。比如,對(duì)于一對(duì)橫向(xiàng)有重疊的子圖,如果基于左子圖的檢測框處于子圖重疊中線的右側,但與該中線相交,該檢測框就被(bèi)保留,反之則丢棄該檢測框。通過(guò)segmentation-and-fusion方法,與直接合并進(jìn)行NMS的方法相比, 我們在本地檢測驗證集取得了0.2AP的提升。

Embedding部分:

爲了解決行人擁擠帶來的問題,我們采用了Multiple Granularity Network(MGN),如上圖所示。我們首先利用Resnet50-ibn-a[4]提取特征,然後(hòu)使用Triplet loss和Softmax loss計算三個全局特征的損失,僅使用Softmax loss計算局部特征的損失。此外,我們使用了ReID中的常用的訓練技巧來優化MGN的性能(néng)[3]。

Data Association:

我們借鑒了DeepSORT和FairMOT的想法,以檢測框的表觀距離爲主,以檢測框的空間距離爲輔。首先,我們根據第一幀中的檢測框初始化多個軌迹。在随後(hòu)的幀中,我們根據embedding features之間的距離(最大距離限制爲0.7),來將(jiāng)檢測框和已有的軌迹做關聯。與FairMOT一緻,每一幀都(dōu)會通過(guò)指數加權平均更新跟蹤器的特征,以應對(duì)特征變化的問題。對(duì)于未匹配的激活軌迹和檢測框通過(guò)他們的IOU距離關聯起(qǐ)來(阈值爲0.8)。最後(hòu),對(duì)于失活但未完全跟丢的軌迹和檢測框也是由它們的IoU距離關聯的(阈值爲0.8)。

後(hòu)處理:

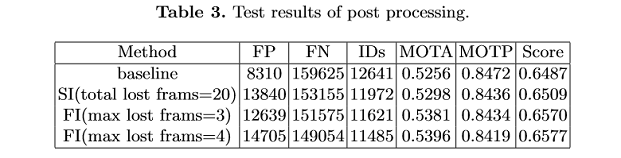

由于隻對(duì)較高的置信度的檢測框進(jìn)行跟蹤,因此存在大量假陰性的檢測框,導緻MOTA[1]性能(néng)低下。爲了減少置信阈值的影響,團隊嘗試了兩(liǎng)種(zhǒng)簡單的插值方法。

1) 對(duì)總丢失幀不超過(guò)20的軌迹進(jìn)行線性插值。我們稱之爲簡單插值(simple interpolation, SI);

2)對(duì)每一個軌迹隻在丢失不超過(guò)4幀的幀之間插入。另外,我們稱之爲片段插值(fragment interpolation, FI)。

雖然插值的方法增加了假陽性樣(yàng)本的數量,但是大大減少了假陰性樣(yàng)本,使我們在測試集上實現了0.9左右的提升。不同插值方法的效果如下表所示。

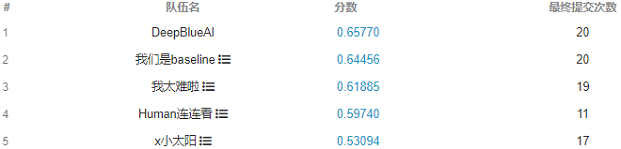

以上是團隊對(duì)參賽方案的優化路線圖,通過(guò)優化檢測器以及特征提取器,數據關聯方法、後(hòu)處理等方法,在GigaVision 2020多行人跟蹤挑戰賽中獲得第一名的成(chéng)績。

總結與思考

本文針對(duì)GigaVision多行人跟蹤挑戰賽,設計了一個簡單、在線的多目标跟蹤系統,包括檢測器、特征提取、數據關聯和軌迹後(hòu)處理,在GigaVision 2020多行人跟蹤挑戰賽中獲得第一名。很榮幸取得這(zhè)次競賽的第一名,在這(zhè)裡(lǐ)也分享一下針對(duì)多目标跟蹤任務的一些問題以及思考:

1)檢測器和特征提取器mAP越高,最終跟蹤的性能(néng)也會相應的提升?2)數據關聯過(guò)程真的需要運動模型麼(me)?3)跟蹤器的特征平滑爲何有效?4)Part-Based的特征提取器爲何有效?

團隊對(duì)以上問題進(jìn)行了思考,得出一些比較簡單的看法:

1) 一般來說檢測器和特征提取器的性能(néng)越理想,最終跟蹤的性能(néng)也會有相應的提升;mAP作爲常用的檢測器評估指标來說,mAP的提升不一定能(néng)帶來跟蹤的性能(néng)提升,當然這(zhè)也和評價指标有關系,需要具體問題具體分析,比如檢測上多尺度增強帶來的AP增益往往會造成(chéng)MOTA的降低。

mAP作爲特征提取器的評估指标來說,mAP的提升也不一定能(néng)帶來跟蹤的性能(néng)提升,比如Part-Based 的MGN在本次競賽中雖然mAP比全局特征提取器差幾個點,在最後(hòu)的跟蹤上卻取得不錯的效果。

2)現實中的多目标跟蹤任務中,攝像頭的突然運動以及跟蹤對(duì)象的突然加速往往都(dōu)是存在的,這(zhè)時候的運動模型其實動态性能(néng)十分的差勁,反而造成(chéng)不好(hǎo)的跟蹤效果,本次競賽采用的是直接不采用運動模型的方法。

3) 跟蹤器的特征平滑操作十分簡單有效,不需要類似于DeepSORT進(jìn)行級聯匹配,速度比較快,考慮了同一軌迹的曆史特征,使得特征更加魯棒,減少了單幀跟蹤錯誤帶來的影響;

4) Part-Based的特征提取器針對(duì)這(zhè)種(zhǒng)遮擋比較嚴重的情況在距離度量時考慮了各個部分的特征,特别的,遮擋部分往往變化比較大,結合特征平滑操作,一定程度上消除了遮擋部分的影響,更關注沒(méi)有遮擋部分的特征。

參考文獻:

1. Bernardin, K. Stiefelhagen, R.: Evaluating multiple object tracking performance(2008)2. Milan, A., Leal-Taixe, L., Reid, I., Roth, S., Schindler, K.: Mot16: A benchmark for multi-object tracking (2016)3. Luo, H., Gu, Y., Liao, X., Lai, S., Jiang, W.: Bag of tricks and a strong baseline for deep person re-identification (2019)4. Pan, X., Luo, P., Shi, J., Tang, X.: Two at once: Enhancing learning and generalization capacities via ibn-net (2018)5. Wang, X., Zhang, X., Zhu, Y., Guo, Y., Yuan, X., Xiang, L., Wang, Z., Ding,G., Brady, D.J., Dai, Q., Fang, L.: Panda: A gigapixel-level human-centric video dataset (2020)6. Wojke, N., Bewley, A., Paulus, D.: Simple online and realtime tracking with a deep association metric (2017)7. Yu, F., Li, W., Li, Q., Liu, Y., Shi, X., Yan, J.: Poi: Multiple object tracking with high performance detection and appearance feature (2016)8. Zhang, Y., Wang, C., Wang, X., Zeng, W., Liu, W.: A simple baseline for multi-object tracking (2020)9. Li, X., Wang, W., Wu, L., Chen, S., Hu, X., Li, J., Tang, J., Yang, J.: Generalized focal loss: Learning qualified and distributed bounding boxes for dense object detection. arXiv (2020)10. Wang, G., Yuan, Y., Chen, X., Li, J., Zhou, X.: Learning discriminative features with multiple granularities for person re-identification. CoRRabs/1804.01438(2018)11. Cai, Z., Vasconcelos, N.: Cascade r-cnn: Delving into high quality object detection. In: Proceedings of the IEEE conference on computer vision and pattern recognition.pp. 6154–6162 (2018)12. Cao, Y., Xu, J., Lin, S., Wei, F., Hu, H.: Gcnet: Non-local networks meet squeeze-excitation networks and beyond. In: Proceedings of the IEEE International Conference on Computer Vision Workshops. pp. 0–0 (2019)13. Dai, J., Qi, H., Xiong, Y., Li, Y., Zhang, G., Hu, H., Wei, Y.: Deformable convolutional networks. In: Proceedings of the IEEE international conference on computer vision. pp. 764–773 (2017)14. Hu, J., Shen, L., Sun, G.: Squeeze-and-excitation networks. In: Proceedings of the IEEE conference on computer vision and pattern recognition. pp. 7132–7141 (2018)15. Li, X., Wang, W., Wu, L., Chen, S., Hu, X., Li, J., Tang, J., Yang, J.: Generalized focal loss: Learning qualified and distributed bounding boxes for dense object detection. arXiv preprint arXiv:2006.04388 (2020)16. Solovyev, R., Wang, W.: Weighted boxes fusion: ensembling boxes for object detection models. arXiv preprint arXiv:1910.13302 (2019)